Umělá inteligence v dokumentárním filmu: etika deepfakeů

Téma deepfakeů v dokumentárních filmech v sobě nese hned tři úrovně etických diskuzí: problém uvnitř samotné technologie, problém při procesu tvorby a problém výsledné recepce děl, které deepfaky používají. Britský režisér a filmový teoretik Dominic Lees, který letos vystoupí na Konferenci o etice v dokumentárním filmu v rámci MFDF Ji.hlava, přináší několik zajímavých případů, na nichž etiku deepfakeů rozvíjí.

Kapitola je přeložená z anglického originálu “Artificial Intelligence in documentary filmmaking: the ethics of deepfakes”, publikované v knize The Ethics of Documentary Film, který editovala Agnieszka Piotrowska pro vydavatelství Edinburgh University Press.

Tvůrčí využití umělé inteligence v dokumentárním filmu je rostoucím fenoménem. Experimentální film Eno (2024) Garyho Hustwita o hudebníkovi a skladateli Brianu Enovi používá na míru vytvořený AI engine, který při každé projekci přeuspořádá střih filmu: žádná verze Ena, kterou diváci uvidí, není stejná jako ta předchozí. Hustwit je součástí nastupující vlny experimentátorů s AI v dokumentární tvorbě. Ačkoli Eno používá technologii k narušení stability textu a divácké recepce, neusiluje o změnu samotného natočeného materiálu. Větší etická výzva pro dokumentární vizuální kulturu nastává, když filmaři využívají generativní AI k vytváření zcela nových obrazů a zvuků.

Dominic Lees je zkušený režisér faktuálních pořadů, dokumentární i dramatické televizní tvorby a zároveň oceňovaný režisér celovečerních filmů. Působí jako docent filmové tvorby na University of Reading ve Velké Británii, kde vede výzkum zaměřený na možnosti využití generativní umělé inteligence ve filmu a na související etické a právní otázky. Současně působí jako odborný poradce pro oblast filmu a vysoce kvalitní televizní tvorby (HETV) při britském parlamentu. Pravidelně vystupuje na mezinárodních konferencích k problematice umělé inteligence ve filmové tvorbě a vede workshopy zaměřené na podporu režisérů při jejím zodpovědném využívání. Ve své nejnovější publikační činnosti se věnuje zejména využití deepfake technologií a generativní umělé inteligence v dokumentární produkci. Dominic Lees je zkušený režisér faktuálních pořadů, dokumentární i dramatické televizní tvorby a zároveň oceňovaný režisér celovečerních filmů. Působí jako docent filmové tvorby na University of Reading ve Velké Británii, kde vede výzkum zaměřený na možnosti využití generativní umělé inteligence ve filmu a na související etické a právní otázky. Současně působí jako odborný poradce pro oblast filmu a vysoce kvalitní televizní tvorby (HETV) při britském parlamentu. Pravidelně vystupuje na mezinárodních konferencích k problematice umělé inteligence ve filmové tvorbě a vede workshopy zaměřené na podporu režisérů při jejím zodpovědném využívání. Ve své nejnovější publikační činnosti se věnuje zejména využití deepfake technologií a generativní umělé inteligence v dokumentární produkci. |

Generativní AI je označení pro škálu výpočetních procesů navržených k tvorbě nového mediálního obsahu – obrázků, textu, zvuku a videa – pomocí metod strojového učení aplikovaných na rozsáhlé objemy tréninkových dat. Širší povědomí o generativní AI se soustředí na hojně používané textové chatboty (systémy GPT, LLaMA aj.), avšak pro dokumentaristy byly transformativní spíše nástroje pro manipulaci obrazu a hlasu – známé jako deepfakey. Tato kapitola zkoumá, jak dokumentaristé deepfaky ve své praxi používají, a rozebírá klíčové etické otázky, které vyvstávají jak ze strany samotných filmařů, tak jejich publik. Začíná vymezením pojmu deepfake a historickým přehledem technologií, a poté nabízí konceptuální rámec pro tři způsoby nedávného použití v dokumentech. Abychom porozuměli tvůrčím záměrům a technologickým procesům, které podnikli klíčoví filmaři v této oblasti, využíváme případové studie a rozhovory. Volba této metodologie záměrně rozvíjí etnografický přístup, který staví do popředí hlasy filmařů a umožňuje jim vyjádřit kulturní a etické obavy vyplývající z jejich praxe. Tento přístup, zaměřený na filmaře, představuje sám o sobě etické stanovisko a navazuje na metodologický příklad projektu MIT Open Documentary Lab, která dala prostřednictvím série otevřených přednášek (MIT 2020) hlas průkopnickým filmařům (Bill Posters, Halsey Burgund, Francesca Panetta), kteří použili deepfaky k nastartování debaty (viz též Peele 2018). Klíčovým rysem této práce je ústřední postavení etické debaty hned v několika úrovních: uvnitř samotné technologie, v procesu dokumentární výroby a v recepci těch dokumentárních filmů, které integrovaly deepfaky do svého tvůrčího procesu.

Vymezení deepfakeů: technologie klamu

Deepfaky jsou automatizované manipulace lidských obrazů a hlasů v digitálním videu a jsou součástí rostoucí oblasti „syntetických médií“. Převládající porozumění deepfakeům je, že jde o techniku nahrazení původní tváře, zachycené ve videu, tváří jiné osoby pomocí procesů strojového učení, avšak populární užití pojmu jej spojuje také s manipulací pohybů rtů tak, aby odpovídaly pozměněné řeči, a se zvukovými deepfaky (neboli klonováním hlasu) (Ajder a Glick 2021, 9). Původ deepfakeů se datuje rokem 2017, kdy bylo strojové učení použito k vkládání tváří hollywoodských hereček do pornografických filmů; jde o fenomén, který odhalila průlomová reportáž Samanthy Cole (2017), jež odkryla rozsah zneužívání obrazů žen v „deep pornu“. Tento převažující způsob použití (více než 90 %) deepfakeů byl tematizován několika dokumentaristy, kteří odhalovali traumatickou zkušenost žen, jež se staly oběťmi nekonsensuálního deepfake porna. V roce 2022 odvysílala britská BBC3 film Jess Davies Zneužití tváře v pornografii: Budete to příště vy? popisující zneužívání deepfakeů. Celovečerní dokument Jiné tělo (Sophie Compton a Reuben Hamlyn, 2023) sleduje pátrání mladé Američanky po spravedlnosti poté, co na internetu uvidí nekonsensuální deepfake pornografii se svým obličejem, a orgány činné v trestním řízení odmítnou její případ dál řešit.

Deepfakeů se dosahuje aplikací umělých neuronových sítí a existuje více přístupů navržených odborníky na počítačové vědy (Tolosana et al. 2020), přičemž nedávné výstupy ukazují překvapivě přesvědčivé příklady ve vysoké obrazové kvalitě. Druhou, příbuznou kategorií audiovizuální manipulace jsou takzvané „cheapfakes“, které Aneja a kolektiv popisují jako „obecný termín zahrnující mnohé ne-AI („cheap“) manipulace multimediálního obsahu, vytvořené bez použití metod hlubokého učení“ (2021: 2). Paris a Donovan zmapovali spektrum AV manipulace od sofistikovaných, na AI náročných deepfakeů až po jednoduché cheapfakey „využívající konvenční techniky, jako zrychlování, zpomalování, střih, pře-hrání scén či re-kontextualizaci záběrů“ (2019, 6). V této kapitole vylučuji „cheapfakes“ či „shallowfakes“ ze svého zkoumání a soustředím se na mainstreamové dokumentární kultury a vysílací média, vytvářející deepfake syntetické obsahy ve vysokém rozlišení.

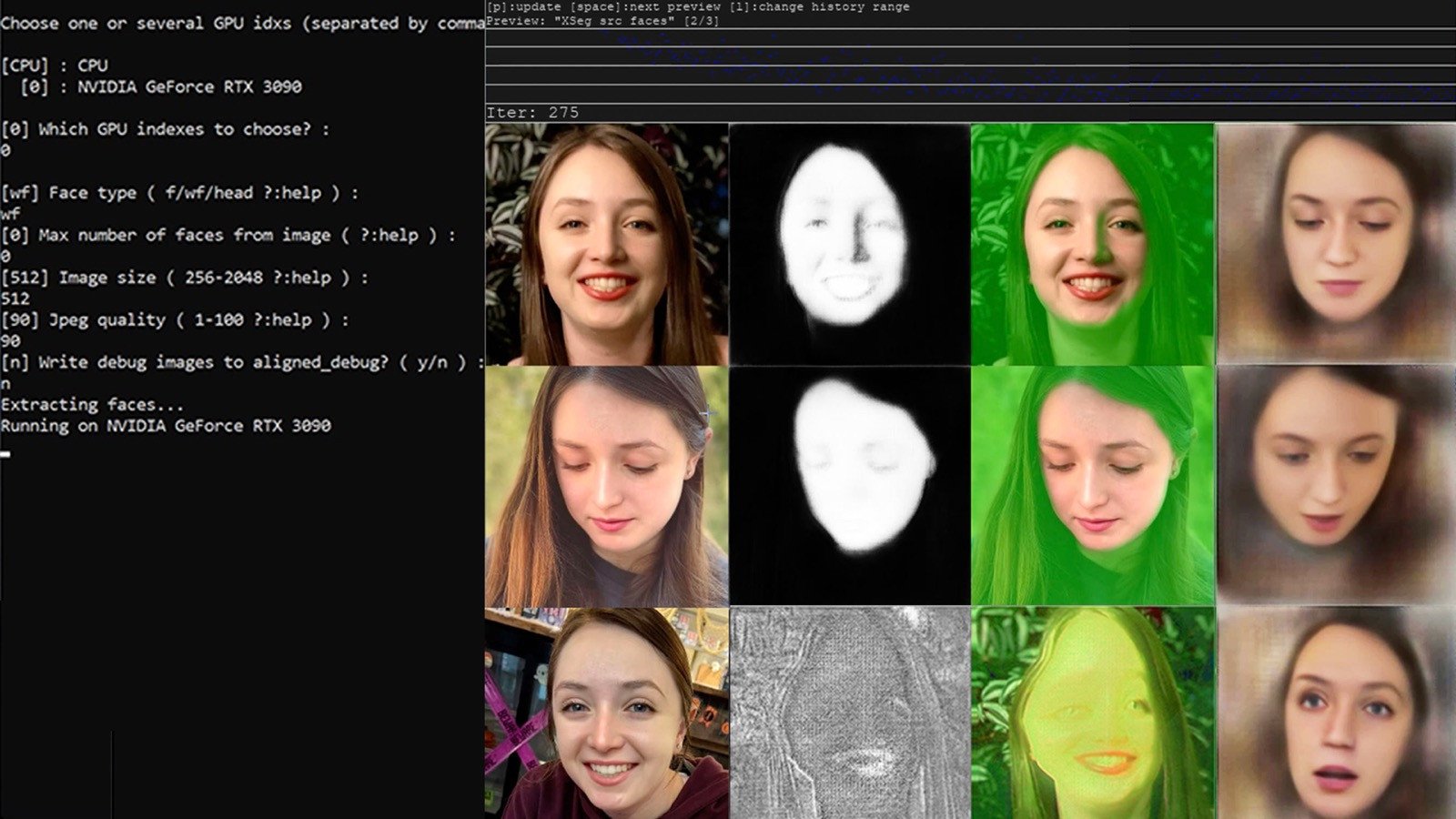

Ve všech případech je „deepfake“ proces, při němž je zaznamenaný subjekt pozměněn a divákovi je prezentován syntetizovaný obraz (a někdy i hlas) osoby, který je kompozicí předkamerového materiálu a počítačem generovaného obrazu. Je třeba poznamenat, že tento popis by stejně tak mohl platit pro tvorbu VFX sekvencí ve filmech; klíčový rozdíl je však v procesu tvorby. Deepfaky zahrnují automatizovanou manipulaci obrazu, na rozdíl od kreativního zapojení VFX umělce při tvorbě počítačově generovaných obrazů: technik strojového učení nastaví generativně-adverzariální síť (GAN) s klíčovými snímky zdroje a cíle a poté nechá neuronovou síť, aby samostatně generovala nové obrazy. V rámci tohoto procesu tvorby deepfakeů je podvod zakódován už na té nejzákladnější úrovni. GAN jsou formou strojového učení, v níž je generátor trénován tak, aby vytvářel falešné obrazy až do bodu, kdy jeho rival, diskriminátor, již nedokáže rozlišit mezi jemu předloženým falešným obrazem a obrazem skutečným. Toto vnitro-počítačové sebenalhávání, zabudované do procesu generování deepfakeů, zrcadlí divácké reakce na deepfaky, v nichž diváci nacházejí potěšení v hranici mezi viditelně a nepostřehnutelně falešným.

Mainstreamoví dokumentární tvůrci si jsou vědomi svých etických závazků ve vztahu k deepfake podvodům a velmi jasně manipulaci obrazu označují. Ostatně první deepfake v televizním vysílání Velké Británie, The Alternative Christmas Message (Channel 4, 2020), byl explicitním varováním před klamnou mocí deepfakeů. Začíná jako celonárodní projev královny, uprostřed kterého se devadesátiletá panovnice vyhoupne na stůl a tančí, a končí „odhalením“, jež demonstruje techniky použitého podvodu (obr. 1).

“Toto vnitro-počítačové sebenalhávání, zabudované do procesu generování deepfakeů, zrcadlí divácké reakce na deepfaky, kdy lidé nacházejí potěšení v hranici mezi viditelně a nepostřehnutelně falešným.”

Přestože je vše nakonec poctivě přiznáno, i tady je podvod inherentní součástí, stejně jako u všech deepfakeů. To platí také pro recepci: jedním z diváckých potěšení je vychutnávání si pocitu, že byli obelháni, a ocenění technologické dovednosti potřebné k dosažení takového podvodu. Nabízí se paralela s jinou formou zábavy: s obdivem publika ke schopnostem kouzelníka při karetních tricích, a to navzdory tomu, že všichni zúčastnění vědí, že to, čeho jsou svědky, je jen klam. Christmas Message Williama Bartletta patří do žánru mockumentu, a jde tedy o inscenovanou produkci, takže spadá mimo záběr této kapitoly o deepfakech v dokumentárním filmu, nicméně tematizuje otázky klamu a etické odpovědnosti, již filmaři vůči svému publiku cítí. Úroveň upřímnosti – tedy otázka, jak by film měl signalizovat svůj deepfake divákovi – nastoluje pro producenty a vysílatele zásadní debaty. Podrobnou diskuzi etických otázek, s nimiž se dokumentaristé při nasazování deepfakeů setkávají, rozvíjím v pozdější části této kapitoly.

Odborné literatuře o vzniku deepfakeů dominují texty o negativních společenských, genderových a politických dopadech (Vaccari a Chadwick 2020). V rámci informatiky, která objemem publikací o deepfakech vítězí, je důraz výzkumu kladen na detekci a prevenci (Peipeng 2021; Rana 2022). Texty o etickém využití deepfakeů reprezentují Danry (2022) a Gaur (2022) a ve filozofii hodnocení morálního statusu tvorby a šíření deepfakeů téma rozvinuli De Ruiter (2021) a Rini (2020). Badatelé v oblasti práva, například Pavis (2021) a Meskys (2020), publikovali texty o reformách právních rámců, které budou k regulaci deepfakeů zapotřebí. Výzkum v kulturálních studiích se zaměřil na kreativní aplikace technologie (Lees 2021; Mikhailova 2021). MIT Media Lab tento motiv pozitivního využití generativní AI rozvinuli konferencí „Využívat deepfaky pro dobrou věc“ (2022); ve Spojeném království téma dále rozpracovala Synthetic Media Research Network svým sympoziem „Syntetická média a audiovizuální průmysl“ (červenec 2023). Jiný přístup k deepfakeům vychází z komunikačních studií. Graham Meikle je pevně zakotvuje v této disciplíně prohlášením, že „deepfaky jsou především komunikační fenomén: jde o nové způsoby vytváření významů a rovněž o výzvy pro ustálená porozumění tomu, jak se význam vytváří“ (2022: 23–24). Craig Hight (2022) přenáší diskurz do oblasti dokumentárního filmu a vztahuje deepfaky k tématu současné kultury dezinformací. Upozorňuje, že deepfaky se nacházejí v kontinuitě dřívější praxe dokumentaristů: „V dokumentární tvorbě vždy existovalo určité napětí mezi snahou o přesné zachycení reality a nutností upravovat důkazy tak, aby výsledné vyprávění bylo srozumitelné a koherentní“ (2022: 398). Použití deepfakeů je tak napojeno na probíhající diskurz o etice dokumentární praxe, v němž byla manipulace obrazu filmaři ospravedlňována tvrzením, že takové techniky slouží vyššímu cíli – doručit publiku silné dokumentární narativy.

Použití deepfakeů v dokumentární praxi

Případy užití deepfakeů v dokumentech lze uspořádat do tří kategorií podle záměrů filmaře:

- anonymizace

- animování zvukového archivu

- dokumentární imaginace

V této části zkoumám tři případové studie dokumentárních filmů, z nichž každý pomáhá osvětlit nový potenciál deepfakeů při naplňování záměrů těchto kategorií. Film Davida France Vítejte v Čečensku (2020), dokument o pogromech proti queer lidem v Čečensku, je průkopnickým příkladem deepfakeů jako techniky zajištění bezpečí dokumentárních subjektů. Gerry Anderson: A Life Uncharted Benjamina Fieldea je součástí jeho projektu oživování historického zvuku na obrazovce. Film In Event of Moon Disaster Francesky Panetty a Halseyho Burgunda, uvedený na festivalu IDFA v roce 2019, demonstruje šíři výrazového potenciálu, který generativní AI dokumentárnímu filmu poskytuje. V každém z těchto filmů se dokumentaristé potýkají se zásadními etickými ohledy vůči svým subjektům – žijícím i zesnulým. Jejich práce probíhala jen pár let po vzniku technologie deepfakeů, kdy mediální domy a instituce ještě nezformulovaly pokyny pro používání generativní AI. Bez „etických svodidel“, která dnes existují, tito filmaři reagovali na etické výzvy individuálně, zkoumáním své osobní morální odpovědnosti.

1. Anonymizace

Při přípravě dokumentu Vítejte v Čečensku čelil režisér David France problému, před nímž stojí mnozí dokumentaristé: osobnímu ohrožení subjektů. Okamžitě vyvstává klíčová etická otázka: odpovědnost filmařů za bezpečí těch, kdo jejich práci podporují tím, že se v dokumentech objevují. Na queer Čečence byla uplatňována děsivá míra násilí, a právě toto pronásledování chtěl France odhalit světovému publiku. Příslušníci komunit LGBTQ+ v Čečensku čelili jisté smrti, pokud by jejich identita byla v dokumentu odhalena. Namísto tradičních metod používaných filmaři k anonymizaci subjektů se France rozhodl použít systém generativní AI, aby jim umožnil vyprávět jejich příběhy beze strachu z identifikace a brutální odplaty. Maskování vytvořil vedoucí vizuálních efektů Ryan Laney, který použil techniku strojového učení k „přemalování“ nové tváře. Tento nástroj nazývá „cenzorním závojem“ (censor veil).

Dokumentární subjekty anonymizované pomocí cenzorního závoje mohou podávat své svědectví s důvěrou, že nebudou identifikovány a pronásledovány. Tato technika představuje zásadní zlepšení oproti dřívějším metodám anonymizace používaným v dokumentech – „rozmazané ploše“ či nasvícení do „siluety“. Cenzorní závoj zachovává výrazové prvky nonverbální komunikace, které byly dřívějšími technikami potlačeny. Laney popisuje, že „veškeré výrazy a emoce, které skrze tyto závoje procházejí, pocházejí od původní osoby, jen tvar obočí, tvar rtů a tvar nosu jsou jiné. Pokud to vezmete z filmařského hlediska, je to spíš jako nasazení protetiky.“ (Moser 2021)

“France deepfake popisuje jako nástroj, který mění to, co lidé dělají, zatímco jeho využití technologie lidem umožňuje být sami sebou.”

Laney vytvořil pro zamaskované subjekty rozmazávací efekt s digitální „svatozáří“ kolem jejich obličejů, aby si publikum po celou dobu filmu uvědomovalo, že jde o technologickou manipulaci. Taková poctivost vůči divákům, jasný úmysl nemystifikovat, je jednou z reakcí dokumentaristů na etické otázky obklopující tuto technologii. David France zdůrazňuje toto etické stanovisko: „Publikum ví, že k tomu došlo, a ví, že se dívá na digitálně upravené tváře. Lidé, jejichž tváře jsou upravovány, to požadovali a schválili. Osoba, která svou tvář darovala, tak učinila s vědomím, že podstupuje riziko, a učinila tak jako akt aktivismu. Vše je záměrem, na všech úrovních provedení“ (tamtéž).

Stejně jako u mainstreamových dokumentů využívajících deepfaky je na začátku jasný disclaimer, který diváka informuje o použití syntetických obrazů. France ale nemá rád termín deepfake: popisuje jej jako nástroj, který mění to, co lidé dělají, zatímco jeho využití technologií lidem umožňuje být sami sebou. Jeho titulek uvádí, že byli „digitálně zamaskováni“ (digitally disguised), nikoli deepfakováni.

Laneyho systém pro anonymizaci, cenzorní závoj, nabízí jako nástroj společnost Teus Media. Dokumentární filmaři na toto používání generativní AI reagovali pozitivně. Emma Sullivan jej použila v Do hloubky: Případ vraždy v ponorce (2020), Jennifer Ngo ve Faceless (2021) a Toby v Hong Kong’s Fight for Freedom (2022). Sophie Compton a Reuben Hamlyn systém využili ve snímku Jiné tělo (2023) o oběti deepfake porna bojující za spravedlnost, což umožnilo jejich subjektu „Taylor“, aby bez zábran vypovídala o své zkušenosti s nekonsensuálním zneužitím své podoby.

2. Animování zvukového archivu.

Tato část se zabývá prací britského producenta a režiséra dokumentárních filmů Benjamina Fielda, průkopníka používání deepfakeů jako prostředku animování zvukového archivu z 20. století. Field využil poprvé generativní AI pro film Gerry Anderson: A Life Uncharted (2022) z produkce The Format Factory a Anderson Entertainment. Je o životě britského tvůrce dětských televizních pořadů Gerryho Andersona, zodpovědného za kultovní pořady Zlo nemá šanci (ITC Entertainment, 1965–66) a Captain Scarlet and the Mysterons (ITC Entertainment, 1967–68). Jamie Anderson, nejmladší syn loutkáře, poskytl dvacet pět hodin zvukových nahrávek rozhovorů se svým otcem, které veřejnost nikdy neslyšela. Filmaři původně neměli v úmyslu použít deepfake technologii. Field ale zápasil s tím, jak udělat staré nahrávky zajímavými. Dokonce zvažoval použití loutek, ale jeho koproducent ho ujistil, že to rodina neschválí. Tyto diskuse probíhaly v roce 2021, krátce poté, co Chris Ume zveřejnil průlomově přesvědčivé deepfakey Toma Cruise, které se virálně šířily na TikToku (2021). Field komentuje dopad těchto videí takto: „Viděl jsem to právě v době, kdy jsme hledali způsoby, jak pracovat se zvukovým archivem, a ty dvě věci prostě do sebe zapadly.“

Field tak objevil nový způsob použití deepfakeů v dokumentární produkci jako prostředek animování zvukových nahrávek. Zvukové archivy jsou zásadní formou svědectví, relevantní pro více modů dokumentárního filmu a faktického obsahu, avšak vždycky představovaly výzvu pro filmaře, jak vytvořit pro hlasy dostatečné množství obrazového materiálu. Použití deepfakeů k vytvoření syntetického rozhovoru „na kameru“ s dokumentárním subjektem, který pronáší svá slova ze zvukového archivu, může tento problém vyřešit.

V rané fázi tohoto použití byl zvuk pomocí AI spojován s už existujícím videozáznamem. Například v aplikaci Reface, která byla hojně používána pro spoustu videí na YouTube, si lidé přidávají svou vlastní tvář nejčastěji do scén hollywoodských filmů. Benjamin Field navrhoval složitější proces, jak oživit svůj archiv starých audiokazet.

Poté, co Craig Morris pořad koupil pro Britbox, producenti hledali ještě další financování. Podepsali smlouvu s Abacus Media Rights, která obsahovala překvapující ustanovení: hotový film musí obsahovat minimálně deset minut vysoce kvalitního deepfake materiálu. K Fieldovu úžasu se novost deepfake technologie stala obchodovatelnou. Field obsadil herce Rolyho Hydea jako dvojníka Gerryho Andersona. Bylo důležité, aby byl herec Andersonovi co nejpodobnější, pokud jde o velikost a tvar hlavy, a to představovalo dva značné problémy: Anderson byl plešatý, na rozdíl od Hydea, a tvary jejich hlavy nebyly úplně shodné. Tým se rozhodl použít tradiční analogové maskérské a vlásenkářské techniky, aby rozdíl zmenšil. V průběhu dvoudenního filmování se natočila scéna Hydea na pohovce, v interiérovém rozhovorovém prostředí; úkolem herce bylo pronést celkem 53 minut vybraného materiálu ze zvukového archivu Gerryho Andersona a pokusit se co nejpřesněji synchronizovat pohyb rtů s originálem.

Za vytvoření deepfakeů pro Gerry Anderson: A Life Uncharted byl zodpovědný Christian Darkin. S předchozí zkušeností ve vizuálních efektech se Darkin vydal autodidaktickou cestou k osvojení generativní AI, která by mohla produkovat deepfake obrazy. Těšilo ho, že mohl přistoupit k open source deepfake algoritmu DeepFaceLab, který „už byl natrénován na stovkách různých cizích obličejů, takže [ví], jak obličej vypadá“. S tímto náskokem mohl Darkin začít specifický proces, který si film o Gerrym Andersonovi žádal: „Pak jej musíte dotrénovat na člověka, kterého se snažíte nahradit, a na člověka, kterým jej nahrazujete. Učí se, jak produkovat kombinaci těch dvou.“

Nicméně s omezenými prostředky dostupnými v The Format Factory byl proces „tréninku“ obzvlášť pomalý, a to si vyžádalo změnu přístupu, omezující rozsah digitální transformace, kterou Darkin po AI požadoval: „Spouštěl jsem ten proces asi tři nebo čtyři týdny na celou hlavu, a pořád to nebylo dobré. Ale pak jsem to zkusil jen na obličej, a po pár dnech to vypadalo velmi dobře.“

“Ve filmu jsou archivní deepfake klipy Gerryho Andersona vidět na starých televizích ze 60. let, které divákům navodí atmosféru období, kdy byl loutkář aktivní.”

Darkin zdůrazňuje, že vytvoření deepfake postavy zahrnuje dva oddělené technické procesy: nejprve neuronové renderování AI a poté tradiční vizuální efekty. Druhé je nezbytné proto, že výstup generovaný deepfake procesem zanechává v obrazu glitche. Ve svém přehledu technických procesů deepfakeů Seow poznamenává, že „v důsledku nestability trénování GAN většina deepfake výstupů obsahuje jemné stopy nebo otisky, jako neobvyklé texturové artefakty nebo nekonzistenci pixelů“ (2022, 367). Příkladem v této případové studii byly vizuální artefakty v místě, kde byl nový obličej připojen k cílovému obrazu. Darkinův deepfake proces vygeneroval nový obličej Gerryho Andersona, a ten byl pak superponován na video herce Rolyho Hydea v inscenovaném rozhovoru, ale to zanechalo zřetelně viditelné spoje v rámci kompozitního obrazu: „V místě, kde je připojíte k sobě, zůstává linie. Tu můžete rozostřit, aby byla méně nápadná. Můžete barevně korigovat pleť původního obrázku s pletí nového materiálu, kterým jej nahrazujete, a tím to vylepšit.“

Rozlišení obrazu bylo pro filmaře dalším problémem. V důsledku výpočetního výkonu potřebného k tvorbě deepfakeů byly v raných letech technologie produkovány ve velmi nízkém rozlišení. To je zanedbatelné při šíření deepfake videí na mobilních zařízeních, ale nedostatečné v kontextu HD vysílání. Nyní už máme strategie pro deepfakey ve vysokém rozlišení (Naruniec et al. 2020), ale tehdy Darkin zjistil, že při použití dostupných nástrojů byla maximální šířka obrazu obličeje, kterou mohl generovat, 320 pixelů, ve srovnání s plnou HD šířkou obrazovky 1092 pixelů. To znamenalo, že velikost hlavy Gerryho Andersona v záběru bude muset být velmi malá. Benjamin Field vymyslel řešení: ve filmu budou archivní deepfake klipy Gerryho Andersona vidět na starých televizích ze 60. let, které divákům navodí atmosféru období, kdy byl loutkář aktivní.

Darkin byl rozhodnutím svého režiséra nadšen: „Byl to chytrý, kreativní způsob jak to udělat, v zásadě nám umožnil trochu odzoomovat, posunout deepfake trochu víc do dálky, snížit počet pixelů, které musel pokrýt.“ Darkin toho zároveň využil jako prostředku k maskování jakýchkoli neopravitelných vizuálních artefaktů vytvořených AI: „Když to někde nefungovalo, mohli jsme na to dát trochu statického šumu.“

3. Dokumentární imaginace – In Event of Moon Disaster (2019)

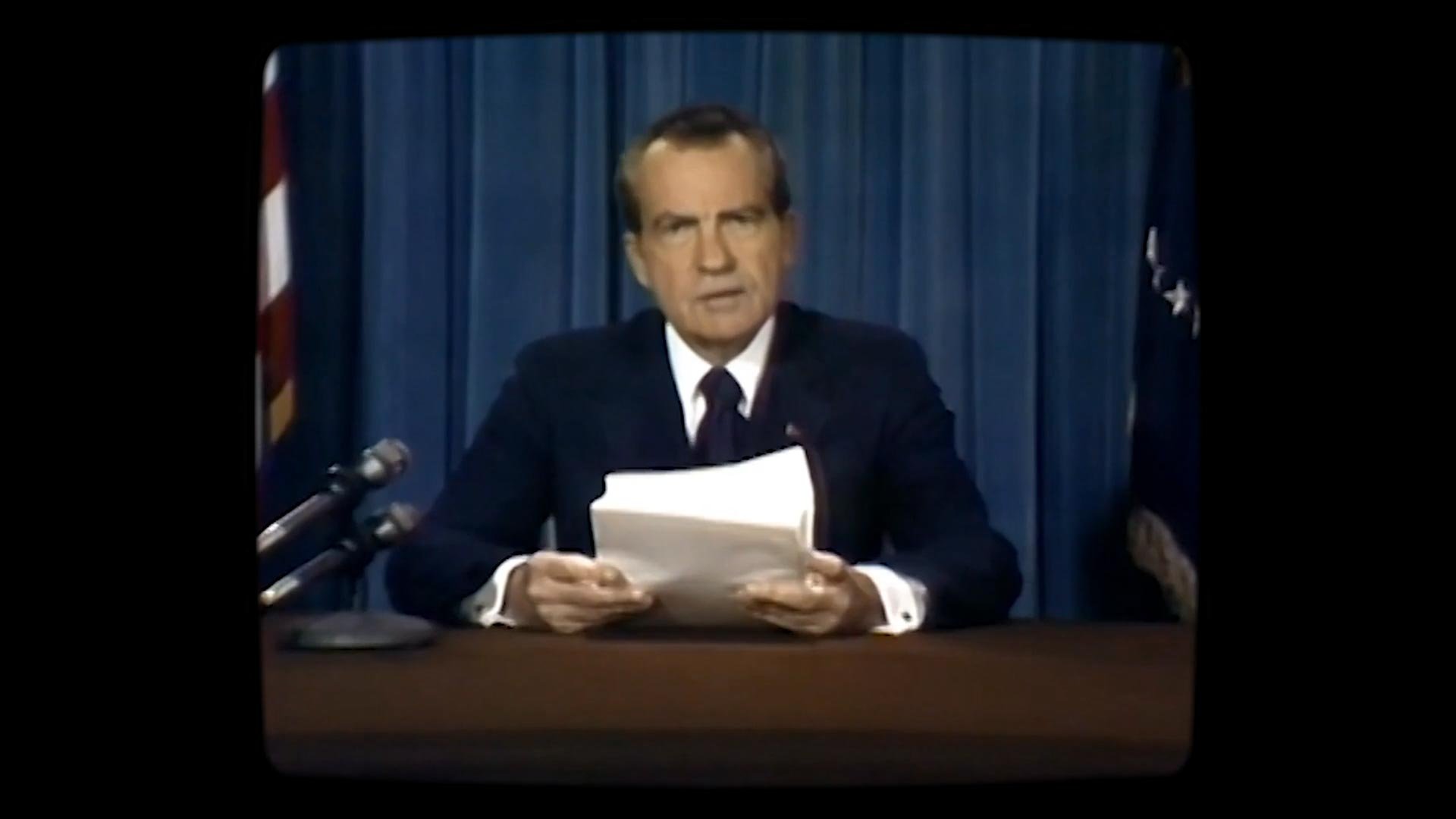

Při misi Apollo 11, prvním pilotovaném letu na Měsíc, hrozilo, že technická chyba nebo nehoda zabrání astronautům Měsíc opustit. Jako opatření pro nejhorší scénář sepsal prezidentův řečník, Bill Safire, projev k národu, který mohl prezident Nixon pronést v případě měsíční katastrofy“ (Safire 1969). V roce 2019 zadal Massachusetts Institute for Technology (MIT) spolupráci mezi XR kreativní ředitelkou svého Centre for Advanced Virtuality Francescou Panettou a Halseym Burgundem z Open Documentary Lab MIT, a to s cílem použít deepfake technologii k animování projevu, který nebyl nikdy pronesen.

In Event of Moon Disaster (V případě katastrofy na Měsíci) je multimediální projekt, který v roce 2021 vyhrál cenu News and Documentary Emmy Award za vynikající interaktivní dokument. Zahrnuje webové stránky, sedmiminutový film a instalaci. Je součástí programu Arts at MIT, který má „skrze umění formovat veřejnost, aby kriticky uvažovala ohledně deepfakeů a dezinformací“ (z webu In Event of Moon Disaster). Pro účely této kapitoly se moje analýza soustředí na tvůrčí rozhodnutí ve využití deepfakeů.

“Kreativní využití syntetických médií nám pomáhá vstoupit až na půdu magického realismu.”

Možnost, kterou Panettě a Burgundovi poskytly nové technologie strojového učení, spočívala v tom, nechat hlas Richarda Nixona pronést slova, která nikdy neřekl. Tato schopnost vytvořit vzorce řeči, fonémy a návyky, které jsou k nerozeznání od skutečného hlasu, je zde jádrem „falešnosti“. V rukou škůdců může tato technologie vytvářet vážná narušení politického diskurzu (Łabuz a Nehring, 2024). Nicméně když je kreativně využita experimentální umělkyní a kurátorkou, jakou je Francesca Panetta, expertkou na imerzivní vyprávění, technologie se stává schopnou větší nuance a hlubšího významu. V rozhovoru Panetta mluvila o konceptuální bohatosti, kterou technologie poskytuje při tvorbě nových deepfake filmů z archivu: „Pro mě deepfakey nabízejí příležitost představovat si jak spekulativní historii, tak spekulativní budoucnost. Může jít o dokument, ale kreativní využití syntetických médií nám pomáhá vstoupit až na půdu magického realismu. Technologie má sílu stírat hranice mezi pravdou a fikcí, vytvářet nejasnost mezi realitou a nereálnem.“

Generativní AI technologie může vytvářet obrazy a videa tak neočekávané a strhující kvality, že je publikum často vnímá jako magické. Při vytváření alternativní historie s touto výjimečnou silou AI technologií Panetta a Burgund experimentovali.

K dosažení falešného Nixonova projevu byly potřeba dva prvky audiovizuální manipulace. Šlo o oddělené AI procesy: prvním bylo klonování hlasu Richarda Nixona pro projev, který nikdy neučinil; druhým byly deepfaky pro vytvoření videa projevu z alternativního dobového zpravodajského záběru. Filmaři pracovali se dvěma technologickými společnostmi: Respeecher, aby vytvořila audio, a CannyAI, aby vytvořila video. Volba cílového videa byla pro tento projekt zásadní; při vytváření deepfaku má totiž cílové video zásadní význam pro určení konečných kvalit syntetického média. Několik autorů sice psalo o In Event of Moon Disaster jako o důležitém momentu ve vývoji deepfakeů (Ajder a Glick 2021; Mustak 2023), nedostatečná kritická pozornost však byla věnována právě videoarchivu, který si filmaři nakonec zvolili. Panetta a Burgund si vybrali rezignační projev, který Richard Nixon pronesl po skandálu Watergate 8. srpna 1974. Tato volba byla důležitá, protože tento projev ztělesňuje paralelní emoce k Safireovu projevu. Ve své rezignační řeči je Nixon sklíčený, poražený, ale zachovává si vzdor. Tyto velmi osobní rysy se staly klíčovými kvalitami nového filmového artefaktu, který vidíme; emoce politika z roku 1974 se výmluvně překlápějí do tragiky alternativní historie zobrazené v In Event of Moon Disaster. Film Burgunda a Panetty se stává intermediální adaptací mezi politickým archivem a deepfake syntetickými médii.

a. Respeecher – klonování prezidentova hlasu

Respeecher je společnost se sídlem v Kyjevě, která si vydobyla postavení světového lídra v klonování hlasu a své know-how nabízí tvůrcům filmů, videí a online obsahu. CEO Respeecheru, Alex Serdiuk, a vedoucí pro etiku a partnerství, Anna Bulakh, poskytli pro tuto kapitolu rozhovory. Role Respeecheru při tvorbě In Event of Moon Disaster začala se zvukovým „hrubým materiálem“ – projevy Richarda Nixona – dodaným týmem MIT. Tyto zvukové soubory se staly datasetem, který se použil k natrénování algoritmu strojového učení pro Nixonův hlas. Serdiuk popisuje další fázi procesu: „Pak jsme potřebovali dalšího člověka, který by byl performerem Nixona, který by dělal voiceover pro nové repliky.“ Panetta a Burgund najali herce Lewise D. Wheelera, aby namluvil Safireův projev. Serdiuk jej popisuje jako „skvělého performera, který dokázal reprodukovat způsob mluvy, přízvuk, způsob, jakým Nixon tehdy mluvil. Požádali jsme jej, aby nahrál stejný dataset, který jsme měli pro Richarda Nixona, takže musel jít větu po větě, úsek po úseku a zachovat stejné emoce.“

Tento komentář obsahuje dva důležité body, týkající se tvorby postav v syntetických médiích. Na rozdíl od běžných hereckých rolí, které Lewis D. Wheeler hraje a v nichž je jeho výkon osobní interpretací postavy, do níž je obsazen, byl u In Event of Moon Disaster požádán, aby přednesl Safireův projev s pečlivou imitací samotného Richarda Nixona. Výkon vyžadoval, aby si Wheeler představil, jak by Nixon text Moon Disaster pronesl, a aby jej věrně nahrál, rekonstruoval prezidenta jako člověka, nikoli jako fiktivní postavu, jak by tomu bylo v životopisném filmu. Tento princip imitace zúžil rozdíl mezi cílovým videem a zdrojem, což usnadnilo práci systému pro konverzi hlasu, který byl následně použit k propojení hereckého výkonu s hlasem Richarda Nixona.

„Nevěřím, že lidský herecký výkon je něco, co by mohlo být technologií do jemných nuancí reprodukováno.“

Druhý Serdiukův postřeh je, že klíčovou vlastností technologie syntetických médií je její omezení, pokud jde o replikaci lidských emocí. Deepfaky jsou syntetická média, ale pro publikum jsou to herecké výkony na obrazovce, a bude se očekávat, že vykazují přirozené emoce, bez nichž budou syntetické postavy nepřesvědčivé nebo robotické. Serdiuk zdůrazňuje, že „u emocí se spoléháme na lidi, takže lidé jsou také nejlepší zárukou, a my jejich výkony v zásadě při naší konverzi neměníme, jen aplikujeme jiný hlasový aparát. Takže je to obvykle otázka obsazení dobrého herce, který dokáže podat výkon přesným způsobem nebo dokáže reprodukovat konkrétní emoce v projevu, které jsou pro daný cílový hlas typické.“

Respeecher ukazuje, že je možné zachovat lidské emoce, obsažené ve zdrojových datech, pomocí kvalit své vlastní technologie „speech to speech“. Ta se výrazně liší od technologie „text to speech“, která zní často roboticky – protože postrádá zásah lidského herce. Jednou z nejpůsobivějších vlastností In Event of Moon Disaster je jeho emocionální intenzita, vycházející jak z výmluvné síly Safireova scénáře, tak ze skutečných lidských emocí v Nixonově rezignaci a ze smyslu pro tragédii, který Lewis D. Wheeler vnáší do svého hlasového projevu.

Při diskusi o projektu čtyři roky po jeho vzniku Serdiuk nastínil, kolik se toho v technologii změnilo. Rychlost a přesnost se zlepšily, přičemž procesy, které v roce 2019 trvaly týdny, nyní Respeechru zaberou jen dny: „Systém se změnil asi z 90 %. Máme sice stejný přístup, ale způsob, jak trénujeme systém, požadavky na data, rychlost, kvalitu výstupu, robustnost systému – to vše se zlepšilo.“ Klíčové omezení technologie – tvorba emocí v klonovaných hlasech – však přetrvává. Serdiuk věří, že to bude trvalý rys klonování hlasu: „Osobně nevěřím, že lidský herecký výkon je něco, co by mohlo být technologií do jemných nuancí reprodukováno.“

b. Rty prezidenta Nixona

Role společnosti CannyAI v projektu spočívala v manipulaci se záběry Nixonova rezignačního projevu tak, aby se zdálo, že prezident pronáší Safireův text. Deepfakes jsou populárně chápány jako výměna obličejů v digitálním videu, ale úplný přenos nebyl v tomto případě vyžadován. CannyAI vyvinula technologii neuronového renderování nazvanou Video Dialogue Replacement (VDR), proces, který dokáže nahradit člověku obličej novým obličejem téže osoby, ale pronášejícím jiná slova. CannyAI natrénovala svůj systém s archivními záběry prezidenta Nixona a audia od Respeecheru. Následně „vyhalucinovala“ alternativní obrazy Nixonovy hlavy, v nichž se pohyby Nixonových rtů shodují s řečovými vzorci nového hlasu. Nakonec VDR vrátilo novou hlavu do původního videa. Pro diváka je jediným vizuálním rozdílem mezi původním rezignačním projevem a Safireovým projevem pohyb rtů prezidenta.

Etika používání deepfake technologie

Diskuse o etice používání deepfake technologie v dokumentárním filmu se protíná s probíhajícími debatami o etice digitálna (Floridi 2018), a konkrétně umělé inteligence (Ashok 2022), zejména o problémech vyvolaných strojovým učením. Někteří autoři hledají ideální, regulované reakce na technologii „etického strojového učení takzvaně dvojího přínosu: kdy jsou reflektovány příležitosti, ale zároveň předvídány a minimalizovány či odbourány potenciální škody“ (Morley a kol. 2020). Metodologie této kapitoly, zaměřená na filmaře, přináší pragmatičtější přístup, který nám umožňuje naslouchat přímo praktikujícím tvůrcům zápasícím s etickými dilematy, jež jsou používání technologií syntetických médií vlastní.

Použití deepfakeů v dokumentární tvorbě vyvolává zásadní etické otázky. Joshua Rothkopf (2020) se jednoduše ptá: „Proč bychom měli důvěřovat dokumentu, který používá deepfaky?“ Filmař pracující s touto technologii podrývá nárok svého filmu být platnou reprezentací svého subjektu. Primární otázkou tedy je, zda má deepfaky vůbec použít. V předprodukci filmu Gerry Anderson: A Life Uncharted se stal Gerryho syn Jamie koproducentem, a to vytvořilo pro režiséra filmu jedinečné etické prostředí. V rozhovoru Benjamin Field popisuje, jak to byl rozhodující faktor pro jeho přijetí AI:

(Autor): Myslíte, že byste použil deepfaky, kdyby Jamie Anderson nebyl součástí týmu? A kdybyste s ním neměl tak dobrý vztah?

Benjamin Field: Ne. Nemyslím si, že bychom s Gerrym pokračovali, protože Gerry Anderson byl jako osoba neobyčejně tajnůstkářský a jeho archivy byly uzamčené. Velmi kontroloval, co je o něm veřejně známo.

V průběhu natáčení zajišťovala role Jamieho Andersona jako koproducenta dohled nad posmrtnými právy a soukromím jeho otce. Jako koproducent a režisér mohl Field prozkoumávat ambiciózní škálu možností pro vizuální ztvárnění filmu s vědomím, že jeho odvážnější nápady (jako použití loutky k „namluvení“ Gerryho Andersona) by jeho blízký spolupracovník zamítl, pokud by porušovaly hodnoty rodiny a daného člověka. Když Field nastolil koncept vytvořit deepfake Gerryho, překvapilo ho Andersonovo nadšení. Oba ale cítili, že velký průkopník dětské televize byl nadšenec do nových technologií, a proto bylo použití deepfakeů v životopisném dokumentu o němvhodné. Christian Darkin, který byl za použití deepfaků zodpovědný, neviděl v deepfakování Gerryho Andersona etický konflikt: „Byl to jeho syn, kdo měl produkci na starosti, používali jsme audio z rozhovorů, které byly dobrovolně poskytnuté, zjevně to byly věci, které Gerry Anderson chtěl říct a chtěl, aby byly slyšeny.“

“Porno z deepfaku udělalo sprosté slovo, zatímco ve skutečnosti může být velmi užitečným a etickým nástrojem v arzenálu filmařů.”

Při diskusi o své práci dokumentaristy Field vykazuje vysokou míru starostlivosti o etiku své praxe. V době použití bylo ale převládající využití této AI v nekonsensuální pornografii: výzkumná zpráva z roku 2019 zjistila, že 96 % deepfakeů online bylo pornografických a 100 % z nich byly videoobrazy žen (Ajder et al. 2019). V rozhovoru Field vzpomíná na reakci televizních dramaturgů, když v roce 2021 poprvé začal mluvit o použití deepfakeů:

„Vidíte lidi, jak se na schůzkách ošívají […], protože to, s čím deepfake nějakou dobu zápasil, je, že je pošpiněn negativitou […]. Udělalo to z něj sprosté slovo, zatímco ve skutečnosti může být deepfake velmi užitečným a etickým nástrojem v arzenálu filmaře.”

Aby čelil negativnímu vnímání deepfakeů, Field se rozhodl používat ve své práci dokumentaristy termín „etický deepfake“, čímž svou vlastní praxi distancuje od většinového využití této technologie.

Klíčovou etickou otázkou, které čelí producenti, jsou práva herce vystupujícího před kamerou. Po natočení hereckého výkonu je jeho obličej nahrazen deepfake obrazem, což vyvolává zásadní otázky: Co z původního výkonu zůstává? Jaká jsou práva tohoto performera? Těmito otázkami se zabývala odbornice na AI a právní vědkyně Mathilde Pavis, která popisuje, jak AI technologie překročila hranice britského práva: „Deepfake technologie dosahuje něčeho, čeho žádná nahrávací technologie předtím nedosáhla: jsou schopny ve velkém měřítku produkovat vysoce kvalitní, nízkonákladové, realistické imitace výkonů. Imitace nebo reprodukce výkonu není chráněna právy výkonných umělců ani žádným jiným právem duševního vlastnictví v přesném slova smyslu“ (2021, 849).

Realitou je, že filmaři, kteří se rozhodnou deepfaky do své práce začlenit, působí v částečném právním vakuu, s nejistými odpovědnostmi a závazky. Komplikujícím jevem při tvorbě deepfakeů je, že postava, kterou publikum na obrazovce pozoruje, není záznamem jediného výkonu: do deepfaku jsou zapojeny dvě osoby, herec a cílový jedinec, z nichž ani jeden není ve výsledném výstupu autenticky reprezentován. V procesu deepfakování čte AI cílový obličej a mapuje pohyby původního výkonu na něj, čímž vytváří to, co Pavis nazývá „imitací“ daného cílového jedince.

Při výrobě Gerry Anderson: A Life Uncharted čelili producenti dokumentu dvěma vrstvám právních otázek: právům k audiu a právům performera. Povolení použít zvukový rozhovor s Andersonem bylo možné získat způsobem dokumentaristům známým; nicméně otázky práv najmutí herce k provedení rozhovoru byly složité. Dokumentaristé najímají herce často, například za účelem natáčení rekonstrukčních sekvencí, ale tento deepfakový projekt byl právně a definičně nejednoznačný. Benjamin Field popisuje potíže, kterým čelil při hledání performera, který by hrál Gerryho Andersona: „První tři odmítli, protože nikdo nevěděl, co deepfake je. Nedokázali jsme definovat, co je to za roli. Hrají? Jsou dublérem? Co jsou? Jak je zaplatíme? Pro různé práce jsou různé sazby, a nikdo mi nedokázal říct, jestli hrají, protože to není jejich hlas, ale je to jejich pohyb.“

Field zjistil, že herecké agentury byly zmatené povahou a statusem práce, o kterou byli jejich klienti žádáni, což přispělo ke ztrátě dvou potenciálních kandidátů. Problém ukázal, jak příchod syntetizovaného výkonu generovaného AI do mainstreamu vyžaduje dramatické zvýšení kvalifikace a sdílení znalostí napříč audiovizuálním průmyslem. V roce 2022 britská herecká unie Equity uvedla, že „79 % performerů, kteří se věnovali AI práci, mělo pocit, že před podpisem smlouvy plně nerozuměli svým právům výkonných umělců (jak jsou stanovena v Copyright, Designs and Patents Act 1988)“ (Equity 2022, 4). Unie na tuto výzvu reagovala kampaní Stop AI Stealing the Show.

V důsledku tohoto zmatku kolem definice deepfake výkonu a práv herců se musí dokumentární producenti spoléhat na svůj osobní morální úsudek. V nepřítomnosti buďto pokynů, nebo samoregulace odvětví a bez relevantního právního rámce je to pouze individuální citlivost dnešních mainstreamových filmařů, co omezuje používání technologie, která se v nesprávných rukou již prokázala jako destruktivní nástroj.

„Nejde jen o ochranu naší technologie, jde také o ochranu společnosti.“

Někteří autoři se zabývají tím, jak je budování strategií odpovědné praxe klíčové pro úspěšné inovační podniky ve výpočetní technice a kreativní AI (Stahl et al. 2016; Flick a Worrall 2022). Pro společnosti pracující na tvorbě deepfakeů v mediálním obsahu mohou etické výzvy, které technologie představuje, vytvořit riziko pro úspěch jejich podnikání. Zakladatelé společnosti pro klonování hlasu Respeecher od počátku své práce v roce 2018 chápali, že důvěra je pro jejich podnikání klíčová: pokud by klienti postrádali důvěru v jejich etické praktiky, obchodní základ firmy by byl podkopán. Spoluzakladatel Alex Serdiuk popisuje, že „etické prohlášení je něco, s čím jsme Respeecher začali, to je první věc, kterou jsme ve společnosti vybudovali. A naše etické prohlášení se skládá z několika důležitých věcí, jako je mít svolení a nepodílet se na tom, aby naše technologie byla používána k podvodným účelům.“ Společnost jmenovala ředitelku etiky Annu Balukh. Ta zdůrazňuje, že etické vyhodnocení předložených obchodních návrhů vede k zamítnutí 80 % z nich. Diskutované záležitosti se jen zřídka týkají práv: „Mnoho otázek není striktně právních, většina z nich je v této fázi etická.“ Dalším rysem praxe společnosti je, že Respeecher se odpojil od dominantního trendu, v němž vývojáři sdílejí svůj open source kód strojového učení. Serdiuk tvrdí, že „nejde jen o ochranu naší technologie, jde také o ochranu společnosti: naše firma nevidí společenský přínos v tom, aby se její vysoce přesvědčivá technologie klonování hlasu stala všeobecně dostupnou”.

Důraz Respeecheru na udržení vysokých etických standardů podpořil i vysoce kontroverzní případ klonování hlasu v dokumentárním filmu Roadrunner: Film o Anthonym Bourdainovi (Morgan Neville, 2021). Subjektem filmu je nesmírně populární kuchařská celebrita Anthony Bourdain, který si v roce 2018 vzal život. Nevillův film je svého druhu posmrtnou poctou. Režisér sestavil film z velmi rozsáhlého archivu Bourdainových kuchařských a cestopisných pořadů s myšlenkou „nechat Tonyho vyprávět film posmrtně á la Sunset Boulevard“ (cit. v Rosner 2021). U většiny filmu toho bylo možné dosáhnout z archivu, nicméně něco bylo ve formě e-mailové korespondence, kterou chtěl Neville slyšet pronesenou svým subjektem. Vyhledal technologické řešení, a tak vznikly asi tři věty v celkové délce čtyřiceti pěti sekund, kde publikum slyší deepfake hlas Bourdaina číst jeho vlastní slova. To vyvolalo bouři negativních diváckých a kritických reakcí. Neville své jednání hájil: „Ověřil jsem si u jeho vdovy a správce jeho pozůstalosti, že s tím jsou v pohodě. A podle nich by to Tonymu nevadilo. Nevkládal jsem mu nějaká slova do úst“ (cit. v Martin 2021).

Neville vidí etické ospravedlnění pro použití syntetického audia ve filmu: jeho racionalizace je, že ty věty napsal Bourdain, takže použití AI není klamáním publika. Co tedy vyvolalo negativní reakci? Lze to přičíst dvěma důvodům:

1. Absence on-screen upozornění.

Jasné upozornění publika, že film použil syntetická média, se stalo standardem v mainstreamových deepfakech. Viděli jsme, jak ve Spojeném království The Alternative Christmas Message výslovně připomínala svým divákům použití deepfakeů; Vítejte v Čečensku Davida France rovněž zajišťuje, že publikum nikdy nezapomene, že došlo k výměně obličeje. Jiná odvětví, jako televizní komedie, udržují podobné standardy zveřejnění: Deep Fake Neighbour Wars (ITVX, 2023) nejen že proklamuje použití AI ve svém názvu, ale začíná titulkem, který diváky upozorňuje na své nekonsensuální celebritní deepfaky. Coburn a kol. pozorovali, že negativní veřejná reakce na Nevillovo použití syntetického audia v Roadrunnerovi pramenila z filmařova přijetí odlišného etického stanoviska: „Zvláště u audia vyskytujícího se v dokumentárním filmu – žánru, který staví do popředí prezentaci pravdy a pravdivých informací o důležitých tématech a osobnostech – mnohé zneklidnilo, že Neville odhalil použití AI technologie jen proto, že to náhodou vyšlo najevo v rozhovoru, a i tehdy odmítl identifikovat, které věty byly vytvořeny dodatečně“ (Coburn a kol. 2022, 2).

Významná skupina diváků a kritiků měla pocit, že byla filmařem oklamána; kontroverze začala dominovat recepci dokumentu. Vnímání, že generativní AI technologie je používána jako strategie klamu, navazuje na jiné veřejné podezření, například ve vztahu k těžbě dat a digitálnímu dozoru. Přenos takových obav do recepce dokumentárního filmu naznačuje potenciálně vysoce škodlivý kulturní dopad deepfakeů. Případ Roadrunner potvrzuje, že mezi filmařem a publikem musí být vybudována pevná důvěra ohledně použití AI technologie, přičemž jasné zveřejnění je pro tento vztah zásadní.

2. Nedostatek souhlasu

Když byl v časopise GQ publikován rozhovor s Morganem Nevillem (Martin 2022), v němž filmař uvedl, že získal souhlas vdovy Anthonyho Bourdaina vytvořit syntetický hlas, byla tato výpověď rychle zpochybněna. Bývalá manželka celebrity, Ottavia Busia, na Twitteru popřela, že souhlasila s tím, že „Tony by s tím byl v pohodě“. Zdálo se, jako by Morgan Neville pokračoval ve svém tvůrčím konceptu „hlas ze záhrobí á la Sunset Boulevard“, aniž by měl jasný a jednoznačný souhlas rodiny zesnulého muže. Syntetické audio je použito v obzvlášť citlivém momentu vyprávění, kdy umělec David Choe čte e-mail, který dostal od svého přítele, zesnulé celebrity, a poté se hlas smísí s hlasem Bourdaina. Neville vytváří velmi dojemný moment, kterého bylo možné dosáhnout pouze prostřednictvím AI. Možná intenzitu negativní divácké reakce způsobila kombinace afektivního dopadu scény a vědomí, že byla vytvořena prostřednictvím nekonsensuálního deepfaku. Kontext nekonsensuálních pornografických deepfakeů zůstává v myslích publika přítomen jako ošklivý původ této technologie, a proto jsou ověřitelné mechanismy souhlasu životně důležité, mají-li být deepfaky v dokumentech používány.

Je třeba poznamenat, že v této kontroverzi Morgan Neville obdržel jak negativní, tak podpůrné komentáře. Nicméně rozsah reakce na jeho etickou racionalizaci ukazuje důležitost, aby dokumentaristé přijali jasně stanovené standardy při používání syntetických médií. Případ Roadrunner ukazuje, jak důležitý je přístup Respeecheru k etickým standardům, zejména vyžadování souhlasu před vytvořením všech klonů hlasu.

Závěr: Etika a samoregulace

Etici poskytli teoretickou platformu, která je vysoce aplikovatelná na dokumentaristy zabývající se kreativním používáním generativní AI. Práce Shannon Vallor o etice a technologii načrtává primární technomorální hodnotu poctivosti, která vyžaduje „vzorový respekt k pravdě“ (2016, 122). Tato kapitola ukázala, že mnozí z mainstreamových dokumentaristů, kteří použili deepfaky, se ve svém rozhodování řídili právě těmito hodnotami. Benjamin Field používá generativní AI za účelem zobrazování skutečného. Říká, že vnitřně klamavá povaha deepfakeů nenarušuje jeho záměr používat AI k lepší reprezentaci zvukového archivu: „Na deepfake se dívám jako na způsob jak říkat pravdu.“ Flick a Worrall rozvíjejí Vallorinu etickou strukturu a komentují, jak se aplikuje na vztah tvůrce a diváka: „Filmaři by měli být povinni zajistit, že publikum ví, že to, s čím interaguje, je AI-generované“ (2022, 84). V eticko-právních diskusích kolem deepfakeů ve filmu a televizi (Pavis 2021) se o tom mluví jako o „povinnosti zveřejnění“.

Viděli jsme, jak rané používání deepfakeů v dokumentární produkci probíhalo v nepřítomnosti právních či regulatorních rámců. Někteří aktéři v audiovizuálním průmyslu na to reagovali vypracováním návrhů směrnic, které by měli zodpovědní tvůrci dodržovat. Organizace Partnership on AI (PAI) se široce zabývá otázkami správy a regulace umělé inteligence. V roce 2023 zveřejnila svůj dokument „Framework for the ethical and responsible development, creation, and sharing of synthetic media“ (Partnership on AI 2023). Tento dokument stanovuje silné principy upravující postupy tvůrců využívajících deepfaky, například zásadu: „Oznámit, pokud vámi vytvořený nebo použitý mediální materiál obsahuje syntetické prvky, zejména v případě, že neznalost této syntézy mění způsob, jakým je obsah vnímán“ (2023, 5). Organizace uvádí, že zastupuje různé zainteresované strany, ale tyto aktéry nejmenuje, a zároveň uvádí, že nebude auditovat subjekty, které se k PAI hlásí. Její „Framework“ velmi přesně reaguje na řadu etických otázek souvisejících se syntetickými médii, včetně těch, které byly nastoleny v příkladu Morgana Nevilleho výše; nicméně jeho dopad bude záviset na širokém přijetí a odpovědné implementaci – což je problém, který se objevuje v mnoha formách samoregulace v oboru.

Také vysílatelé a zpravodajské organizace formulovaly své reakce na generativní AI, například Pařížskou chartou o AI a žurnalistice (2023) a pokyny BBC pro tvůrce programů, které se zabývají klíčovými etickými otázkami a vyvažují veřejné poslání instituce se zásadou „umožnit kreativní využití nových forem vyjádření“ (BBC, 2024). Pro dokumentaristy je důležité, že generativní AI je dovolena pouze tehdy, pokud „nenarušuje původní význam obsahu, nedeformuje význam událostí, nemění dopad autentického materiálu ani jinak zásadně neuvádí publikum v omyl“. Tato pravidla znamenají, že Roadrunner Morgana Nevilleho nemůže být v současné podobě vysílán BBC (film je dostupný na Apple TV).

Vznik takových etických mantinelů pro využívání AI je vítaný, neboť poskytuje vodítka dokumentárním filmařům pracujícím v hlavním televizním a streamovacím prostředí. Mimo tuto oblast, zejména v online médiích, však neetické využívání deepfaků a dalších forem generativní AI v oblasti faktického obsahu zůstává rozšířené. Na TikToku se například objevuje řada „trauma porn“ videí, která využívají generativní AI k „oživování“ zemřelých dětí. Platforma čelila velké kritice v roce 2023 po zveřejnění deepfaku Jamese Bulgera, uneseného a zavražděného v roce 1993, ve kterém „mluví“ o tom, jak byl zabit. Jeho matka se k dopadu deepfaku vyjádřila: „Použít tvář a pohybující se ústa dítěte, které už tu není, které nám bylo brutálně vzato, na to nejsou slova“ (Bryrne 2023). Ačkoli je pozoruhodným rysem generativní AI demokratizace přístupu k pokročilým nástrojům pro manipulaci s obrazem, které byly dříve dostupné pouze produkcím s vysokým rozpočtem, současnou výzvou je, jak zajistit etickou regulaci obsahu vytvořeného těmito nástroji napříč všemi úrovněmi distribuce.

Překlad: Tereza Domínová

---

Poznámky:

Ajder, Henry, Giorgio Patrini, Francesco Cavalli, and Laurence Cullen. (2019) The State of Deepfakes: Landscape, Threats, and Impact. Amsterdam: Deeptrace. https://regmedia.co.uk/2019/10/08/deepfake_report.pdf

Ajder, Henry and Joshua Glick. (2021) Just joking: deepfakes, satire and the politics of synthetic media. Cambridge, Mass: MIT Open Documentary Lab https://cocreationstudio.mit.edu/just-joking/

Another Body, directed by Sophie Compton and Reuben Hamlyn, 2023. US: WILLA/Impact Partners.

Aneja, Shivangi, Cise Midoglu, Duc-Tien Dang-Nguyen, Michael Alexander Riegler, Pål Halvorsen, Matthias Nießner, Balu Adsumilli, and Chris Bregler. (2021) MMSys’21 Grand Challenge on Detecting Cheapfakes. In 12th ACM Multimedia Systems Conference (MMSys’21), Sept. 28-Oct. 1, 2021

Ashok, M., R. Madan, A. Joha, and U. Sivarajah. (2022) 'Ethical framework for Artificial Intelligence and Digital technologies', International Journal of Information Management, 62.

BBC. 2024. Guidance: the use of Artificial Intelligence https://www.bbc.co.uk/editorialguidelines/guidance/use-of-artificial-intelligence#:~:text=The%20BBC%20has%20made%20clear,will%20be%20open%20and%20accountable.&text=-%20never%20undermine%20the%20trust%20of,effective%20and%20informed%20human%20oversight

Byrne, Paul. (2023) ‘James Bulger's mum's fury at sick TikTok AI clip of her 'son' talking about his murder’. https://www.mirror.co.uk/news/uk-news/james-bulgers-mums-fury-sick-30580334

Captain Scarlet and the Mysterons, created by Gerry Anderson and Sylvia Anderson, 1967-8. UK: ITC Entertainment.

Coburn, Claire, Kat Williams and Scott R. Stroud. (2022) ‘Enhanced Realism or A.I.-Generated Illusion? Synthetic Voice in the Documentary Film Roadrunner’, Journal of Media Ethics, DOI: 10.1080/23736992.2022.2113883

Cole, Samantha. (2017) ‘AI-Assisted Fake Porn Is Here and We’re All Fucked’, Vice. https://www.vice.com/en/article/gydydm/gal-gadot-fake-ai-porn

Danry, V., Leong, J., Pataranutaporn, P., Tandon, P., Liu, Y., Shilkrot, R., Punpongsanon, P., Weissman, T., Maes, P., and Sra, M. (2022) ‘AI-Generated Characters: Putting Deepfakes to Good Use’, CHI Conference on Human Factors in Computing Systems Extended Abstracts (CHI ’22 Extended Abstracts), April 29-May 5, 2022, New Orleans, LA, USA.

Deepfake porn: you could be next, directed by Jess Davies, 2022. BBC 3.

De Ruiter, Adrienne. 2021. ‘The Distinct Wrong of Deepfakes’, Philosophy & Technology 34: 1311–1332.

Deep Fake Neighbour Wars, directed by Spencer Jones, 2023. UK:ITVX

Eno, directed by Gary Hustwit, 2024. UK: Tigerlily Productions.

Equity. (2022) Stop AI Stealing the Show. https://www.equity.org.uk/media/6134/report-stop-ai-stealing-the-show.pdf

Faceless, directed by Jennifer Ngo, 2021. US/Hong Kong: Dissonant Productions.

Flick, C., Worrall, K. (2022) ‘The Ethics of Creative AI’, in The Language of Creative AI edited by C.Vear and F. Poltronieri. Cham: Springer. https://doi.org/10.1007/978-3-031-10960-7_5

Floridi, L. (2018) ‘Soft Ethics and the Governance of the Digital’. Philos. Technol. 31, 1–8 https://doi.org/10.1007/s13347-018-0303-9

Feuerriegel, S., Hartmann, J., Janiesch, C. et al. (2024) ‘Generative AI’, Bus Inf Syst Eng 66, 111–126 (2024). https://doi.org/10.1007/s12599-023-00834-7

Gaur, L, ed. (2022) DeepFakes: Creation, Detection, and Impact. 1st ed. CRC Press: Boca Raton.

Gerry Anderson: A Life Uncharted, directed by Benjamin Field, 2022. UK: BritBox.

Here, directed by Robert Zemeckis, 2024. US: Sony Pictures.

Hight, Craig. (2022) ‘Deepfakes and documentary practice in an age of misinformation’, Continuum, 36(3): 393-410. DOI: 10.1080/10304312.2021.2003756

Hong Kong’s Fight for Freedom, directed by Toby Paton, 2022. UK: BBC.

In Event of Moon Disaster, directed by Francesca Panetta and Halsey Burgund, 2019. US: MIT. https://moondisaster.org

Into the Dee, directed by Emma Sullivan, 2020.

Łabuz, M., Nehring, C. On the way to deep fake democracy? Deep fakes in election campaigns in 2023. Eur Polit Sci (2024). https://doi.org/10.1057/s41304-024-00482-9

Lees, Dominic, Thomas Bashford-Rogers and Marcus Keppel-Palmer. (2021) ‘The digital resurrection of Margaret Thatcher: creative, technological and legal dilemmas in the use of Deepfakes in screen drama', Convergence: the International Journal of Research into New Media Technologies, 27(4): 954-973. https://dx.doi.org/10.1177/13548565211030452

Martin, Brett. (2021) ‘What was Anthony Bourdain searching for?’ GQ magazine. https://www.gq.com/story/anthony-bourdain-morgan-neville-roadrunner-documentary

Meikle, Graham. (2022) Deepfakes. Cambridge: Polity Press.

Meskys, E., A. Liaudanskas, J. Kalpokiene, and P. Jurcys. (2020) 'Regulating deep fakes: legal and ethical considerations', Journal of Intellectual Property Law & Practice, 15: 24-31.

Mihailova, Mihaela. (2021) ‘To Dally with Dalí: Deepfake (Inter)faces in the Art Museum.’ Convergence: The International Journal of Research into New Media Technologies, 27(4): 882–898. https://doi.org/10.1177/13548565211029401

Morley, J., L. Floridi, L. Kinsey, and A. Elhalal. (2020) 'From What to How: An Initial Review of Publicly Available AI Ethics Tools, Methods and Research to Translate Principles into Practices', Science and Engineering Ethics, 26: 2141-68.

Moser, Joey. (2021) ‘Welcome to Chechnya VFX Supervisor Ryan Laney and Director David France detail how veiling identities helped save lives’, Awards Daily https://www.awardsdaily.com/2021/03/08/welcome-to-chechnya-vfx-supervisor-ryan-laney-and-director-david-france-detail-how-veiling-identities-helped-save-lives/

Mustak, Mekhail, Joni Salminen, Matti Mäntymäki, Arafat Rahman, Yogesh K. Dwivedi. (2023) ‘Deepfakes: Deceptions, mitigations, and opportunities.’ Journal of Business Research, 154: 113368 https://doi.org/10.1016/j.jbusres.2022.113368.

MIT Open Documentary Lab. (2020) Deepfakery: a livestream talk series http://opendoclab.mit.edu/?s=deepfakery

Naruniec, J., Helminger, L., Schroers, C. and Weber, R.M. (2020) ‘High-Resolution Neural Face Swapping for Visual Effects’, Computer Graphics Forum, 39: 173-184. https://doi.org/10.1111/cgf.14062

Paris, Britt and Joan Donovan. (2019) Deepfakes and Cheap fakes: the manipulation of audio and video evidence https://www.archives.gov/files/presidential-libraries/events/centennials/nixon/images/exhibit/rn100-6-1-2.pdf

Partnership on AI. (2023) PAI’s Responsible Practices for Synthetic Media: A Framework for Collective Action. Online: PAI https://partnershiponai.org/wp-content/uploads/2023/02/PAI_synthetic_media_framework.pdf

Pavis, M. (2021) Rebalancing our regulatory response to Deepfakes with performers’ rights. Convergence, 27(4): 974–998. https://doi.org/10.1177/13548565211033418

Peele, Jordan. (2018) ‘A Public Service Announcement from Monkeypaw Productions and BuzzFeed’, YouTube https://www.youtube.com/watch?v=cQ54GDm1eL0

Peipeng Yu, Zhihua Zha, Jianwei Fei, Yujiang Lu. (2021) ‘A Survey on Deepfake Video Detection’, IET Biometrics 10 (6): 607-624

Pietrobon, Agnese. (2020) ‘Are we not going to be able to ever know what the truth is, again?’ - Halsey Burgund (IN THE EVENT OF MOON DISASTER)’, Online: XRMust. https://www.xrmust.com/xrmagazine/halsey-burgund-event-moon-disaster/

Rana, M.S, M. N. Nobi, B. Murali and A. H. Sung. (2022) ‘Deepfake Detection: A Systematic Literature Review’, IEEE Access 10: 25494-25513. Doi: 10.1109/ACCESS.2022.3154404.

Reporters Without Borders. (2024) The Paris Charter on AI and Journalism. https://rsf.org/en/rsf-and-16-partners-unveil-paris-charter-ai-and-journalism

Rini, Regina. (2020) ‘Deepfakes and the epistemic backstop’, Philosophers’ Imprint 20, 24: 1-16 http://hdl.handle.net/2027/spo.3521354.0020.024

Roadrunner, directed by Morgan Neville, 2021.

Rothkopf, Joshua. (2020) ‘Deepfake technology enters the documentary world.’ The New York Times, July 06 https://www.proquest.com/newspapers/deepfake-technology-enters-documentary-world/docview/2420903688/se-2

Rosner, Helen. (2021) ‘The Ethics of a Deepfake Anthony Bourdain Voice’, The New Yorker online July 17 2021. Available at https://www.newyorker.com/culture/annals-of-gastronomy/the-ethics-of-a-deepfake-anthony-bourdain-voice

Safire, Bill. (1969) Memo to H.R.Haldeman In Event of Moon Disaster. US: Presidential Libraries. https://www.archives.gov/files/presidential-libraries/events/centennials/nixon/images/exhibit/rn100-6-1-2.pdf

Seow, J. W., Lim, M. K., Phan, R. C. W., & Liu, J. K. (2022) ‘A comprehensive overview of deepfake: Generation, detection, datasets, and opportunities.’ Neurocomputing, 513: 351-371. https://doi.org/10.1016/j.neucom.2022.09.135

Stahl, B.C., Timmermans, J. and Flick, C. (2016) ‘Ethics of Emerging Information and Communication Technologies - On the implementation of responsible research and innovation.’ Science and Public Policy, 44 (3): 369-381

The Alternative Christmas Message, directed by William Bartlett, 2020. Channel Four Television. https://www.channel4.com/programmes/alternative-christmas-message

The Book of Boba Fett. 2022. US: Disney

Thunderbirds, created by Gerry Anderson and Sylvia Anderson, 1965-6. UK: ITC Entertainment.

Tolosana, Ruben, Ruben Vera-Rodriguez, Julian Fierrez, Aythami Morales, Javier Ortega-Garcia. (2020) ‘Deepfakes and beyond: A Survey of face manipulation and fake detection’, Information Fusion, 64: 131-148. https://doi.org/10.1016/j.inffus.2020.06.014.

Ume, Chris. (2021) The Chronicles of Deepfake Tom Cruise (Viral TikTok videos). YouTube https://www.youtube.com/watch?v=nwOywe7xLhs

Vaccari, Cristian and Andrew Chadwick. (2020) ‘Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News’, Social Media+Society 6(1): 2056305120903408 DOI: 10.1177/2056305120903408

Vallor, Shannon. (2016) Technology and the virtues: a philosophical guide to a future worth wanting (New York: Oxford University Press)

Welcome to Chechnya, directed by David France, 2020. US: Public Square Films/HBO. https://www.welcometochechnya.com/